- Bài 1: Giới thiệu

- Bài 2: Cài đặt

- Bài 3: Nền tảng toán học của Neural Networks

- Bài 4: Mạng nơron cơ bản

- Bài 5: Tổng quan về machine learning và deep learning

- Bài 6: Triển khai mạng thần kinh đầu tiên

- Bài 7: Functional Blocks và Terminologies

- Bài 8: Loading Data

- Bài 9: Linear Regression ( Hồi quy tuyến tính )

- Bài 10: Convolutional Neural Network ( CNN )

- Bài 11: Recurrent Neural Network ( RNN )

- Bài 12: Tập dữ liệu ( Dataset )

- Bài 13: Giới thiệu về Convents

- Bài 14: Huấn luyện Convent bằng Scratch

- Bài 15: Feature Extraction trong Convents ( Trích xuất đặc trưng )

- Bài 16: Visualization Convents

- Bài 17: Sequence Processing với Convents

- Bài 18: Word Embedding

- Bài 19: Recursive Neural Networks

Bài 7: Functional Blocks và Terminologies - Pytorch Cơ bản

Đăng bởi: Admin | Lượt xem: 2037 | Chuyên mục: AI

Huấn luyện một thuật toán học sâu bao gồm các bước sau:

- Xây dựng đường dẫn dữ liệu

- Xây dựng kiến trúc mạng

- Đánh giá kiến trúc bằng hàm mất mát

- Tối ưu hóa trọng số kiến trúc mạng bằng thuật toán tối ưu hóa

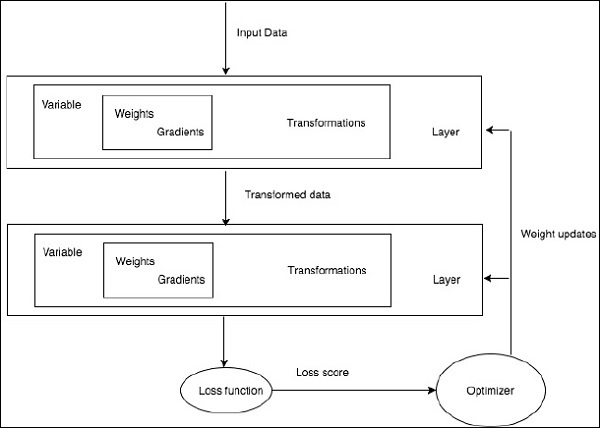

Huấn luyện một thuật toán học sâu cụ thể là yêu cầu chính xác của việc chuyển đổi mạng nơ-ron thành các khối chức năng như hình dưới đây

Đối với sơ đồ trên, bất kỳ thuật toán học sâu nào đều liên quan đến việc lấy dữ liệu đầu vào, xây dựng kiến trúc tương ứng bao gồm một loạt các lớp được nhúng .

Nếu bạn quan sát sơ đồ trên, độ chính xác được đánh giá bằng cách sử dụng một hàm mất mát liên quan đến việc tối ưu hóa trọng số của mạng nơ-ron.

1. PyTorch NumPy :

Một tensor PyTorch giống hệt một mảng NumPy. Tensor là một mảng n chiều và đối với PyTorch, nó cung cấp nhiều chức năng để hoạt động trên các tensor này.

Tensors PyTorch thường sử dụng GPU để tăng tốc các phép tính số. Những tensors này được tạo ra trong PyTorch có thể được sử dụng để điều chỉnh một mạng hai lớp với dữ liệu ngẫu nhiên. Người dùng có thể thực hiện thủ công chuyển tiếp và chuyển tiếp qua mạng.

2. Biến và Autograd

Khi sử dụng autograd, chuyển tiếp mạng của bạn sẽ xác định một đồ thị tính toán - các nút trong biểu đồ sẽ là Tensors và các cạnh sẽ là các hàm tạo ra Tensors đầu ra từ Tensors đầu vào.

PyTorch Tensors có thể được tạo dưới dạng các đối tượng biến trong đó một biến đại diện cho một nút trong đồ thị tính toán.

3. Dynamic Graphs

Đồ thị tĩnh rất đẹp vì người dùng có thể tối ưu hóa đồ thị trước. Nếu các lập trình viên đang sử dụng lặp đi lặp lại cùng một biểu đồ, thì việc tối ưu hóa trước có thể được duy trì khi cùng một biểu đồ được chạy đi chạy lại nhiều lần.

Sự khác biệt chính giữa chúng là đồ thị tính toán của Tensor Flow là tĩnh và PyTorch sử dụng đồ thị tính toán động.

4. Optim Package

Gói tối ưu trong PyTorch tóm tắt ý tưởng về một thuật toán tối ưu hóa được thực hiện theo nhiều cách và cung cấp hình ảnh minh họa về các thuật toán tối ưu hóa thường được sử dụng. Điều này có thể được gọi trong câu lệnh nhập.

5. Đa xử lý

Đa xử lý hỗ trợ các hoạt động giống nhau, do đó tất cả các tensors hoạt động trên nhiều bộ xử lý. Hàng đợi sẽ chuyển dữ liệu của chúng vào bộ nhớ dùng chung và sẽ chỉ gửi một xử lý đến một tiến trình khác.

Theo dõi VnCoder trên Facebook, để cập nhật những bài viết, tin tức và khoá học mới nhất!

- Bài 1: Giới thiệu

- Bài 2: Cài đặt

- Bài 3: Nền tảng toán học của Neural Networks

- Bài 4: Mạng nơron cơ bản

- Bài 5: Tổng quan về machine learning và deep learning

- Bài 6: Triển khai mạng thần kinh đầu tiên

- Bài 7: Functional Blocks và Terminologies

- Bài 8: Loading Data

- Bài 9: Linear Regression ( Hồi quy tuyến tính )

- Bài 10: Convolutional Neural Network ( CNN )

- Bài 11: Recurrent Neural Network ( RNN )

- Bài 12: Tập dữ liệu ( Dataset )

- Bài 13: Giới thiệu về Convents

- Bài 14: Huấn luyện Convent bằng Scratch

- Bài 15: Feature Extraction trong Convents ( Trích xuất đặc trưng )

- Bài 16: Visualization Convents

- Bài 17: Sequence Processing với Convents

- Bài 18: Word Embedding

- Bài 19: Recursive Neural Networks